贮存

stock.adobe.com

为什么未来的人工智能存储可能不得不排除flash

了解为什么大、高节点数和仅硬盘扩展存储架构能够解决不断增长的容量需求和AI架构和工作负载的挑战。

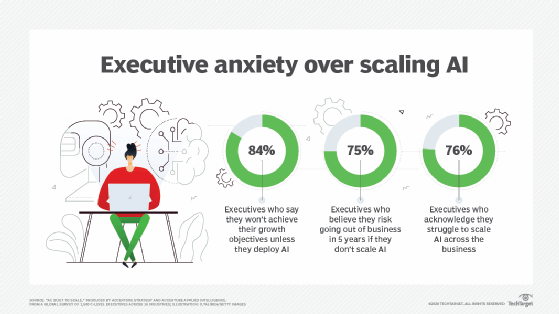

许多机构将在未来几年内投资人工智能。至少,这些投资将用于IT运营,IT将使用AI处理数据中心内系统持续生成的海量遥测数据。不过,大多数企业很可能会开始这么做投资AI应用这将有助于他们更好地运行业务。

然而,支持这些计划的存储基础设施对项目的成功至关重要。如果企业不部署足够的人工智能存储为了支持他们的AI工作负载,这些投资将导致更加放弃和更少的爆炸。

为什么存储对AI至关重要?

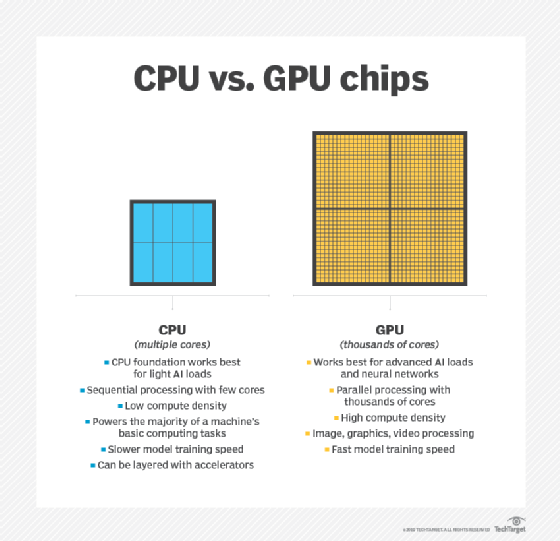

大多数AI工作负载通过处理信息山脉成为“智能”,因此它们可以学习他们以后将管理的环境的行为。AI架构往往遵循传统的设计。大多数是具有部分或全部的计算节点集群节点包含gpu.每个GPU提供多达100个cpu的性能,但这些GPU也比现成的cpu更贵。

一个人工智能存储基础设施的关键作用就是确保这些图形处理器不断地提供数据,这样它们就不会闲置。他们处理的数据通常是数百万,如果不是数十亿,相对较小的文件由传感器或IOT设备创建.因此,AI工作负载的I/O模式通常是顺序读和随机读的混合。

另一个挑战是存储要求。对于AI变得更加复杂 - 更智能 - 它需要处理越来越多的数据。这些高存储容量需求意味着在几年内以100 TB启动的AI项目可以在几年内快速缩放到100个PETABYTES(PB)。300 PB至400 PB范围内的AI容量变得越来越普遍。

在其早期阶段,许多AI项目计算在共享的全闪存阵列上,以提供保持昂贵的GPU繁忙所需的性能。今天,许多AI项目可以充分利用高性能和低延迟的NVME系统,即使在网络上也提供了高性能。随着这些环境的规模和尝试达到高水平的自主权,他们需要更多计算和GPU资源,并且更大的存储空间。

新一代人工智能存储基础设施需要扩展以满足高层自治的容量需求。它还需要扩展以满足扩展计算集群的性能需求。由于组织缩放其AI工作负载,并且它将更多GPU供电的节点添加到这些群集,I / O模式变得更加平行。

缩放AI存储

缩放存储架构解决了下一代AI工作负载所创建的容量挑战。此外,如果它能够直接访问存储群集中的特定存储节点,则可以满足高级AI工作负载的并行I / O需求。但是,并行访问需要新类型的文件系统,因此存储群集不会包含一些管理访问的一些节点的瓶颈。

考虑到大多数人工智能工作需要数十甚至数百拍字节的容量,存储规划者不太可能做到这一点继续使用全闪光作为AI存储基础架构中唯一的存储层。尽管闪光的代价已经大幅下降,但高容量hdd仍然便宜得多。至少就目前而言,现代AI架构需要同时管理闪存和磁盘,并在这些层之间透明地移动数据。然而,这些层的管理需要自动化。

在某些情况下,考虑到工作负载数据集的大小,组织最好构建一个大型、高节点数和仅使用硬盘的集群。这是因为这些工作负载非常大,它们完全超出了任何缓存层。此外,分层数据增加了存储软件的开销,降低了存储速度。一个高节点数、仅硬盘的存储集群可能提供足够的并行性能,以其能够处理的速度继续向gpu交付数据。

人工智能需要高性能计算级别的存储

作为AI工作负载成熟,AI存储基础架构看起来更像高性能计算(HPC.)存储系统比传统的企业存储。这些基础架构几乎肯定会在设计中缩放和 - 由于大量容量需求 - 包含HDD和潜在磁带,具体取决于工作负载配置文件。

同时,flash,因为成本和人工智能和机器学习的速度使用它,可能很快就可以作为这些系统的存储介质呈现。至少,Flash可能最终在AI存储架构中仅在AI存储体系结构中播放小角色,因为这些环境转换为ram,硬盘和磁带的组合。

相关资源

- 成熟的AI解决方案,易于部署,生产就绪和成本效益…datadirect网络