高性能的互联和存储性能

如果您使用的InfiniBand或RDMA在融合以太网作为互连?我们讨论每种技术对性能的影响的功能,如延迟,IOPS和吞吐量。

存储共享一直是储存成本控制和性能优化超过二十年的重要方面。目标是挤压最低成本的最佳性能。

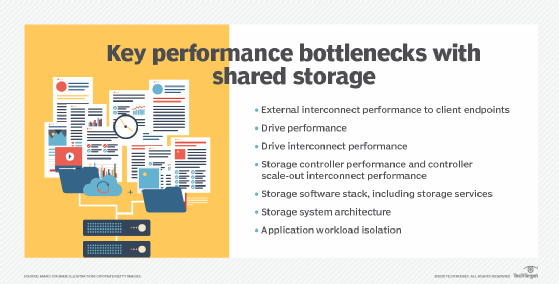

基本上有四种类型的共享存储—块、文件、对象和并行文件—通常在高性能计算(HPC)环境中发现。尽管每种方法都必须解决多个存储瓶颈为了实现其最佳性能,本文将重点讨论与客户端端点的外部互连性能相关的问题。

高性能互连与存储的作用

目前正在市场中的NVMe-炒作为重点,以高性能的互连问题赶上了。NVMe-的是NVMe块协议,它利用远程直接存储器访问优点(RDMA)在不同的互连技术。NVMe- of的主要目的是将应用程序连接到存储系统,就像它是本地NVMe闪存或持久内存驱动器一样。RDMA通过确保接收目标有足够的空闲内存来传输数据来减少延迟。前端延迟对于事务来说很重要。

即利用了应用服务器和目标存储之间RDMA的系统的一个例子可在甲骨文工程化超快Exadata数据库器具被发现。它采用RDMA交钥匙设备内的数据库服务器和存储服务器之间。另一个例子是从Excelero,应用服务器和目标存储之间运行。在这种情况下,Excelero绕过存储CPU而直接进入在存储系统内的驱动器。每个例子演示了使用RDMA的值,但不一定NVMe-的。展馆数据使用NVMe-的应用服务器和存储系统之间。这些方法都提供了非常低的延迟。NVMe-oF支持支持以太网、FC (Fibre Channel)、ib和TCP/IP协议。目前,延迟最低的是InfiniBand、以太网和FC。TCP/IP增加了一些延迟。

显然,100 Gbps或200 Gbps以太网网络接口卡将有超过10 Gbps的NIC更好的性能。无论InfiniBand和以太网可以实现吞吐量高达600 Gbps的(12个链接),他们有未来的规范,可以得到五倍的吞吐量。但要明白,一个200 Gbps的NIC将一个饱和代PCIe 4路公交车是非常重要的。因此,多个200 Gbps的NIC或NIC端口不会双重性能,也不会对400 Gbps的NIC。

FC - 这在32 Gbps的顶出来,并具有128 Gbps的未来规格 - 已经下降带宽高性能后面的比赛。有一些新的FC客户,但安装的企业基地仍预计增长了好几年。然而,它被转移到一个传统的互连。

如果您的高性能互连使用的InfiniBand或ROCE?

前进,大多数高性能互连实现专注于InfiniBand或RDMA通过融合以太网(RoCE)。那两个怎么样协议比较?

建筑学

InfiniBand架构指定了RDMA如何在InfiniBand网络中工作,而RoCE对以太网做同样的工作。InfiniBand RDMA在适配器硅中。RoCE可能在适配器或NIC硅,取决于供应商。RoCE有两个官方版本:RoCE v1和RoCE v2。RoCE v1通过以太网封装ib传输数据包,以太网帧限制为1500字节或巨帧9000字节。RoCE v2基于用户数据报协议(UDP).

ROCE最初使用的InfiniBand动词- 功能和一个InfiniBand API提供的方法。最新的实现也利用Libfabric亚马逊网络服务(Amazon Web Services)、思科系统(Cisco Systems)、瞻博网络(Juniper Networks)和微软Azure都在使用它。

带宽

InfiniBand和以太网都支持高达400gbps的带宽。InfiniBand是一个开放标准,但目前只由Mellanox提供英伟达最近收购了.以太网,从以太网技术联盟的开放标准,被许多厂商,包括Arista网络,阿托科技,博通,Chelsio通信,思科系统,戴尔技术,惠普企业(HPE),华为,英特尔,Juniper网络公司,Marvell的支持科技集团的Cavium公司,Mellanox Technologies公司和西门子。Mellanox公司在这两个InfiniBand和以太网的高性能互连的关键球员,已经在几年前,它需要避免被局限于一个潜在的利基认可。

以太网一直是高性能互连技术的参与者,但InfiniBand由于其较低的延迟和成本而做得更好。然而,以太网已经开始侵蚀这些优势。很少有存储系统具有外部InfiniBand接口——DataDirect Networks、HPE/Cray、IBM、Panasas、Pavilion Data systems和WekaIO——使用InfiniBand作为内部互连的存储系统就更少了。

潜伏

InfiniBand在适配器和交换方面都比以太网具有优势。这是因为InfiniBand网络的许多方面都是在InfiniBand芯片上卸载的,而不是在以太网芯片上。事实上,在InfiniBand规范中调用了卸载。以太网供应商近年来一直在缩小这一差距,特别是在延迟发生最多的nic中。像切尔西和Mellanox这样的供应商已经做了很多缩小延迟差距.

InfiniBand的延迟比以太网交换机高出一个数量级。但这一差距在以太网上已经大大缩小了高性能开关思科(Cisco)和瞻博网络(Juniper Networks)等供应商将这一优势降低了五倍至大约两倍。

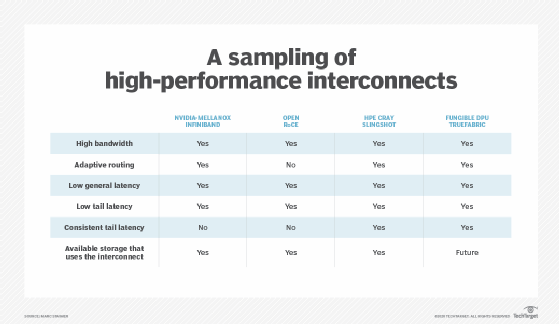

基于带宽和延迟,InfiniBand似乎比RoCE更有优势。但还有其他因素,如拥塞和路由,影响高性能互连。

交通拥堵

拥塞发生在这两个层2成的织物和层3的互连网络。在层2成中的织物 - 诸如FC,InfiniBand和ROCE - 拥塞被称为热点,当某个特定路线或端口上的流量过大时,就会发生这种情况。热点会阻塞或减缓流量,从而对性能产生负面影响。当遇到拥塞时,第二层网络被设计成不会丢包,而第三层网络则会丢包。

InfiniBand使用两个不同的帧中继消息控制拥塞:前进显式拥塞通知(FECN)和后向显式拥塞通知(BECN)。FECN在BECN通知发送设备时有网络拥塞时通知接收设备。Infiniband结合了FECN和BECN具有自适应标记率以减少拥塞。它提供了粗晶拥塞控制,因为它惩罚了每个体验拥堵的人,而不仅仅是违规制度。

在RoCE上的拥塞控制使用显式拥塞通知(ECN),它是IP和TCP的扩展,允许端点网络拥塞通知而不丢弃数据包。ECN在IP报头上做一个标记,告诉发送方出现了拥塞——就像数据包被丢弃了一样——而不是丢弃数据包。在非ecn拥塞通信中,丢弃的数据包需要重新传输。ECN通过拥塞的TCP连接减少数据包丢失,避免重传。更少的重发减少延迟和抖动,提供更好的交易和吞吐性能。然而,ECN还提供了在InfiniBand没有明显的优点粗粒度的拥塞控制。

路由

当网络或网络出现拥塞或热点时,自适应路由在替代路线以缓解拥塞和速度递送发送装置。最新的Mellanox公司的InfiniBand交换机采用自适应路由通知和技术Mellanox公司电话智能数据中心的自我修复互连增强(盾牌)或快速链接故障恢复.

InfiniBand自适应路由使InfiniBand交换机能够根据端口的负载选择输出端口,假设没有对输出端口选择的限制。“屏蔽”使交换机在线性转发表中的输出端口没有处于武装或主动状态且发生故障时,可以选择另一个输出端口。

roce v2在IP之上运行。IP已被路由,几十年具有高级路由算法,现在具有可预测拥塞路由的AI机器学习,并自动发送数据包更快的路由。谈到路由时,以太网和ROCE V2具有显着的优势。

然而,InfiniBand和RoCE都没有做太多的尾延迟,这是最后一个包而不是第一个包的延迟。尾延迟对于HPC消息传递应用程序非常重要同步,以及一些产品的创新已经开始解决这个问题。

高性能互连技术的未来

有几个供应商 - HPE Cray,可替换和隐形启动,无法在此时被命名 - 在下一代高性能互连创新上工作。让我们探索他们正在做的一些工作来增强以太网和roce。

HPE克雷

部分HPE 2019年收购克拉包括基于标准的以太网高性能互连称为弹弓.HPE Cray开发了Slingshot,为其Shasta HPC超级计算机提供了更好的性能ClusterStor发它以光泽为基础的存储和与沙斯塔的联系。

Slingshot使用标准的以太网RDMA,同时添加HPE Cray标签的超集HPC以太网.此超集的架构为HPC流量的需求和在HPC应用程序的小分组消息流行和消息接口协议优化。HPC以太网运行在UDP / IP之上,并同时与所有其他以太网流量。HPE克雷提供了基于具有高度先进的自适应路由和拥塞控制一个应用程序特定的独特的集成电路(ASIC)上的开关。结合使得高性能的网络,规模27个万余端点与他们之间不超过三个跳。弹弓支持所有交换机组网拓扑,包括蜻蜓。

Slingshot的关键是它在延迟和尤其是负载下的尾部延迟的卓越性能。Slingshot对标准化全球性能和拥塞网络测试的结果进行了验证(GPCNet.).Slingshot在平均未加载延迟和平均延迟上没有差异,拥塞大约在1.8微秒(µs)。尾部延迟拥塞更令人印象深刻,99%的包低于8.7µs。在同一个GPCNeT测试上,标准RoCE和InfiniBand通常会有平均10到20倍的延迟,而且延迟更不一致。

弹弓拥塞控制和自适应路由是基于切换的。这使弹弓可以使用各种100/200 Gbps以太网NIC。当前的实现使用NVIDIA Mellanox ConnectX-5 NIC。自适应路由只造粒并只惩罚导致拥塞的各方,没有数据包。遗憾的是,截至2020年,Slingshot只能可用,并作为HPE Cray Shasta HPC超级计算机和伦泰储存的一部分出售,而且使用Shasta超级计算机出售时。

可替代的

Fungible是一家资金雄厚的初创公司,拥有200多名员工。联合创始人是Juniper Networks前创始人普拉迪普·辛杜(Pradeep Sindhu),以及Upthere(已被Western Digital收购)前创始人、苹果软件工程高级副总裁伯特兰·塞莱特(Bertrand Serlet)。

可替代已研制出一种ASIC架构解决CPU问题数据密集处理,如高性能网络和存储。该处理器被称为数据处理单元(DPU)。它不是像Nvidia Mellanox和Chelsio的网卡那样的网络负载,而是旨在以极高的速度促进和加速IP数据包处理和移动。它具有基于端点的拥塞控制和自适应路由,适用于任何标准的高性能以太网交换机。与Slingshot一样,它在持续的基础上最小化跳跃和延迟。与Slingshot不同,asic必须位于启动器和目标网卡上。可替代开发了一种用于启动器的ASIC和另一种用于存储目标的更高吞吐量的ASIC。网络可伸缩性预计将达到数十万个端点。

可替代也开发了软件,叫做TrueFabric,它在UDP / IP之上运行,并与其DPU一起使用。可替换保持了DPU及其trufabric软件设计用于大规模的资源池,减少满足极端存储性能所需的资源,包括交换机数量和存储资源。该公司还声称,ASIC和软件将减少节点之间、节点和存储之间的延迟和尾部延迟,同时提供一致的预测延迟,提高可靠性和安全性。这些说法是基于预测算法的。不过,还是要提醒一下。除非有可重复基准测试的可替换DPU产品可用,否则这些说法很有趣,但未经证实。但基于创始人的出身背景,这是值得探索的。

未命名隐形初创公司

在高性能互联市场上还有一家初创公司,但它目前处于隐形模式,无法公开讨论其计划。该公司正在开发一种通过完全无开关架构实现高性能互连的方法,该架构还可以扩展到数万至数十万个端点,并具有拥塞控制和自适应路由。

使这个非常有趣的是完全消除了开关。预计2021年上半年就能实现。